Le prime tre pratiche vietate dell’AI ACT (2/4)

Analizziamo insieme le prime tre pratiche vietate dell'AI ACT: tecniche manipolative, sfruttamento delle vulnerabilità e social scoring.

Dopo avere esaminato i principi alla base delle pratiche vietate previste dall’art. 5 del Regolamento Europeo 2024/1689 (AI Act), già applicabili dal 5 Febbraio 2025, adesso entriamo nel merito delle singole pratiche, iniziando dalle prime tre:

Art. 5 (1) (a) Sistemi che sviluppano tecniche manipolative o ingannevoli in grado di alterare il comportamento umano e creare un grave danno

Art. 5 (1) (b) Sistemi che sfruttano le vulnerabilità dovute all’età, alla disabilità o a particolare situazioni economiche o sociali

Art. 5 (1) (c) Sistemi di social scoring

Tra i punti centrali dell’articolo 5 vi è il divieto assoluto di adottare quei sistemi che manipolano, ingannano o distorcono il comportamento umano (lettera a), che sfruttano vulnerabilità specifiche (lettera b) o che costruiscono meccanismi di valutazione sociale, noti come “social scoring” (lettera c).

Si tratta di misure che non rispondono a un’esigenza puramente etica, ma alla necessità di proteggere individui e gruppi da interferenze che rischiano di privare di contenuto la libertà di scelta, la capacità critica, il diritto a non essere trattati in modo sfavorevole in base a dati personali o tratti della personalità.

Tecniche manipolative

L’articolo 5, al primo comma, afferma che i sistemi AI sono vietati quando mirano a influenzare il comportamento umano attraverso mezzi occulti o ingannevoli, tali da compromettere la capacità dell’utente medio di compiere scelte informate.

La norma considera in primo luogo quelle tecniche manipolative che, pur agendo sotto soglia – come nel caso degli stimoli subliminali – riescono comunque a orientare le decisioni dell’utente. Ad esempio un video pubblicitario che inserisce immagini o suoni impercettibili a occhio nudo ma che riescono ad attrarre attenzione, preferenza o azione verso un prodotto possono rientrare nel divieto. Accanto a queste pratiche, si possono considerare manipolazioni intenzionali i chatbot progettati per sfruttare le debolezze cognitive dell’utente, o le vere e proprie tecniche ingannevoli, come la simulazione vocale di una persona per truffare il destinatario.

Ciò che accomuna tutte queste pratiche è l’effetto concreto o potenziale di distorcere la volontà dell’individuo, portandolo a compiere azioni che non avrebbe mai fatto in condizioni di piena consapevolezza. Non è necessario che il danno si sia già verificato, basta che sia concretamente possibile.

I danni, nella visione del legislatore europeo, possono essere fisici, psicologici, economici o finanziari.

Il divieto si applica ogni volta che sussiste un nesso di causalità materiale tra la tecnica utilizzata e il danno derivante da un’alterazione reale e significativa della capacità di autodeterminarsi dell’uomo.

La norma obbliga a valutare la gravità del danno, la sua intensità, la durata, l’eventuale irreversibilità, il contesto e la presenza di effetti cumulativi. Non basta dire che una tecnica è discutibile, occorre dimostrare che vi sia un impatto tangibile, valutabile sul singolo caso, sulla base di parametri generali.

Sfruttamento delle vulnerabilità

Accanto al divieto legato alle tecniche manipolative, l’articolo 5 pone un secondo limite in caso di sistemi di sfruttamento delle vulnerabilità.

In questo caso l’attenzione non è tanto sulla tecnica utilizzata, ma sulla condizione del soggetto coinvolto.

Il divieto, infatti, interviene quando l’AI è progettata per influenzare persone particolarmente vulnerabili, come bambini, anziani, disabili o soggetti in difficoltà economica, sfruttando il loro stato per ottenere un effetto manipolativo.

Ad esempio un sistema pensato per vendere prodotti a minorenni, facendo leva sull’immaturità decisionale, o una App che induce una persona anziana, non esperta di tecnologia, a sottoscrivere un contratto finanziario dannoso, possono rientrare nel divieto.

Anche in questo caso è necessario che l’intervento dell’AI comprometta la capacità decisionale dell’utente e produca, o possa ragionevolmente produrre, un danno rilevante.

La discriminante tra i due divieti (lettera a e b) è piuttosto sottile. In linea generale si può dire che il primo opera quando la tecnica è pericolosa in sé, ed ha come scopo o come effetto la distorsione del comportamento umano.

La seconda potrebbe non essere pericolosa in sé, ma lo diventa tenuto conto della particolare condizione di fragilità dell’utente. In entrambi i casi, l’obiettivo è sempre quello di impedire che l’intelligenza artificiale diventi uno strumento manipolatorio.

Il legislatore, però, pur nel rigore del divieto, non esclude in assoluto l’uso di tecniche persuasive. L’AI Act lascia spazio ad alcune eccezioni, riconoscendo che esistono forme di “persuasione lecita” che non compromettono in modo significativo l’autonomia dell’utente. Campagne informative, pubblicità trasparente, suggerimenti di consumo, tutto questo è ammesso, purché non superi la soglia del danno o dell’inganno.

Rimane ovviamente una zona grigia di confine tra lecito e illecito che potrebbe dar luogo a interpretazioni difformi e a una certa incertezza applicativa.

Il social scoring

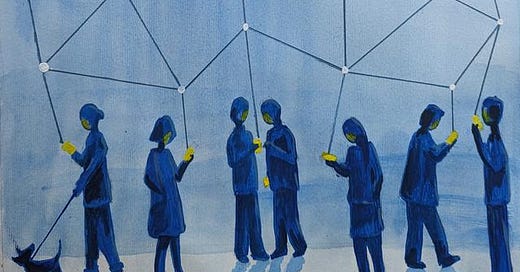

Il “social scoring” è un meccanismo, già in uso in alcuni stati, per cui le persone vengono valutate e classificate in base al loro comportamento sociale, con ricadute concrete sulla vita quotidiana.

Il Regolamento Europeo interviene in modo netto, vietando ogni sistema di AI che assegna punteggi basati su tratti personali o comportamenti sociali, se tali punteggi producono effetti negativi in ambiti non pertinenti. Il divieto si applica anche se il trattamento sfavorevole è “solo” sproporzionato rispetto al comportamento valutato.

Un esempio emblematico può essere quello di un algoritmo che, monitorando i social network, assegna un punteggio basso a un utente in ragione delle sue interazioni online e, in base a questo punteggio, limita il suo accesso a un mutuo o a una polizza assicurativa, pur in assenza di qualsiasi collegamento tra i post pubblicati e il profilo di rischio economico.

La tutela non si ferma alle discriminazioni per età, etnia, genere, religione, ma si estende a qualsiasi trattamento ingiusto o penalizzante, anche solo in termini di maggiore controllo o sorveglianza.

Il principio di proporzionalità

Un principio chiave è quello della proporzionalità, per cui l’uso dei dati e la conseguente classificazione, per essere leciti, devono avere un senso logico, giustificato e coerente con l’ambito di applicazione.

Lo scopo è evitare che si creino società algoritmiche dove la fiducia sociale viene assegnata da macchine e, con effetti devastanti sull’inclusione, la reputazione e la libertà personale.

Anche qui, il regolamento introduce alcune eccezioni.

Ad esempio sono escluse le valutazioni riferite a persone giuridiche, salvo che queste si riflettano in modo diretto sul trattamento degli individui che vi operano e sono esclusi quei sistemi già regolamentati da normative di settore, come il credit scoring nel settore bancario, a condizione che i criteri utilizzati siano trasparenti, pertinenti e proporzionati.

In definitiva, questi divieti mirano a tutelare la capacità e il diritto dell’individuo di decidere liberamente e ad evitare ogni forma di discriminazione occulta.

Grazie per aver letto LISP!

Hai domande sull’AI ACT?

Ho letto e riletto il "EU Artificial Intelligence Act" e, più lo leggo, più mi sembra roba fuori dal mondo, una normativa dissociata dalla realtà.

In italia, a spanne, ci sono 5.000.000 di aziende attive. Per la quasi totalità sono aziende medie, piccole, piccolissime e micro-imprese. Facciamo finta che l'1% userà qualche forma di IA, quindi 50.000 aziende.

Chi controlla 50.000 aziende?

Qualcuno si rende conto di quanto tempo e risorse servano per applicare una normativa tanto complessa e scritta in modo da essere tanto soggetta a interpretazioni?

Qualcuno si rende conto di quante risorse servano, soprattutto in italia, per denunciare qualcuno che viola questa normativa?

Ma questo strato legislativo, a parte gravare pesantemente sulle spalle delle aziende oneste che cercheranno di rispettare anche questa roba, a cosa serve realmente?

A chi serve realmente?